Atualizações sobre o mundo Pentaho

Aquecimento

Para iniciar, cabe uma breve explanação sobre os acontecimentos que têm aquecido o mercado e a comunidade de empresas, usuários e desenvolvedores de soluções de apoio a decisão, que evitam desperdiçar verdadeiros latifúndios com licenças de uso de softwares antigos e criam suas próprias soluções, sob medida, e sem vínculos com quem quer que seja. Nem com vendedores de licenças, nem de servidores nem de consultorias, cursos ou treinamentos caríssimos e infinitos.

Muitos projetos ambiciosos da atualidade, em todo o mundo, só são considerados viáveis por conta das facilidades oferecidas pelo produto Pentaho, uma suíte (um conjunto de softwares integrados entre si) de código aberto, gratuito, que contempla todas as etapas de soluções de Business Analytics e/ou Business Intelligence, end to end. O Pentaho tem sido turbinado, digamos assim, pelas CTools, um conjunto de plugins criados por uma empresa portuguesa, a Webdetails. Em 2013 ela foi comprada pela Pentaho, empresa que mantém o produto com o mesmo nome, que conta com uma versão Enterprise, não gratuita e ainda mais completa que a versão gratuita, a Community. Ambas as versões passam a contar com várias das Ctools como parte integrante, juntamente com o Pentaho Marketplace, responsável pela instalação e gerenciamento de plugins.

Em 2015 a empresa Pentaho foi comprada por um dos maiores grupos do mundo, a Hitachi, um líder global em indústrias, infraestrutura e tecnologia, que tem, entre outros, foco no mercado de IoT, internet das coisas. Eles gerenciam entre outros empreendimentos, usinas nucleares, metrôs, ferrovias e têm uma gama de sensores bastante considerável. Todos estes sensores geram dados, que precisam ser analisados em tempo hábil para que façam algum sentido e ajudem na tomada de decisões, aplicáveis em praticamente todas as esferas da sociedade. Aí é que entra a suíte Pentaho.

Pentaho Day 2017 Brasil - Curitiba/PR

E ao falarmos de Pentaho, cabe aqui destacar, ainda com certo delay, que o Pentaho Day 2017 Brasil - Curitiba/PR foi fantástico, como sempre. Foram tantos aprendizados e tantos contatos estabelecidos, que vários projetos desde então foram executados aqui na e-Setorial e nos consumiram, mas não podemos deixar de enaltecer mais essa iniciativa da comunidade Pentaho Brasil, que ajuda profissionais e empresas de ramos de atividade e portes diferentes. A título de exemplo, nossos projetos este ano foram tão variados, que foram desde a análise de dados de Educação à Distância, do Enriquecimento de Dados de Pessoas Físicas e Jurídicas do Brasil, a análise de dados Hospitalares para Planos de Saúde, até um sistema completo para gestão de risco em Usinas Hidrelétricas e Barragens. Todos desenvolvidos utilizando o Pentaho em sua versão gratuita, atingindo excelentes resultados.

E ao falarmos de Pentaho, cabe aqui destacar, ainda com certo delay, que o Pentaho Day 2017 Brasil - Curitiba/PR foi fantástico, como sempre. Foram tantos aprendizados e tantos contatos estabelecidos, que vários projetos desde então foram executados aqui na e-Setorial e nos consumiram, mas não podemos deixar de enaltecer mais essa iniciativa da comunidade Pentaho Brasil, que ajuda profissionais e empresas de ramos de atividade e portes diferentes. A título de exemplo, nossos projetos este ano foram tão variados, que foram desde a análise de dados de Educação à Distância, do Enriquecimento de Dados de Pessoas Físicas e Jurídicas do Brasil, a análise de dados Hospitalares para Planos de Saúde, até um sistema completo para gestão de risco em Usinas Hidrelétricas e Barragens. Todos desenvolvidos utilizando o Pentaho em sua versão gratuita, atingindo excelentes resultados.

O maior evento da comunidade Pentaho do Mundo, contou com mais de 400 participantes e teve Palestras, Cases e Minicursos ministrados por algumas das maiores referências sobre o tema, que aconteceu na Universidade Positivo, em Curitiba/PR, no Brasil, nos dias 11 e 12 de maio.

O destaque principal ficou para apresentação de Matt Casters sobre o seu fantástico Web Spoon, que é o Pentaho Data Integration rodando inteiramente na web, facilitando ainda mais o desenvolvimento e manutenção das soluções.

Muito do material produzido e apresentado no evento está disponível no site do evento, inclusive o minicurso oferecido por Eduardo Carvalho, da e-Setorial, com o título "Design Patterns para Tuning Pentaho com Ctools".

Espaço para Tietagem

Eduardo Alves de Carvalho

Analista Sênior de BI na e-SetorialTietagem também faz parte! Com @pmalves Pedro Alves e @mattcasters #Pentahoday #pentahoday2017 pic.twitter.com/0rYMehVI69

— Eduardo Carvalho (@educarvalho2001) May 12, 2017

Capricho da organização

A organização do evento foi impecável. Deixamos o agradecimento ao amigo Marcio Junior Vieira, da Ambiente Livre, responsável por mais esta edição do evento.

Hitachi Vantara

Em 18 de setembro de 2017 a Hitachi anunciou a formação da Hitachi Vantara, uma empresa cujo objetivo é ajudar as organizações a prosperar nos tempos incertos e turbulentos de hoje e se preparar para o futuro. Esta nova empresa unifica a missão e as operações da Pentaho, Hitachi Data Systems e Hitachi Insight Group em um único negócio, a Hitachi Vantara. Juntas, dão aos líderes empresariais uma vantagem para encontrar e usar o valor em seus dados, inovar inteligentemente e atingir os resultados que são importantes para as empresas e a sociedade.

Em 18 de setembro de 2017 a Hitachi anunciou a formação da Hitachi Vantara, uma empresa cujo objetivo é ajudar as organizações a prosperar nos tempos incertos e turbulentos de hoje e se preparar para o futuro. Esta nova empresa unifica a missão e as operações da Pentaho, Hitachi Data Systems e Hitachi Insight Group em um único negócio, a Hitachi Vantara. Juntas, dão aos líderes empresariais uma vantagem para encontrar e usar o valor em seus dados, inovar inteligentemente e atingir os resultados que são importantes para as empresas e a sociedade.

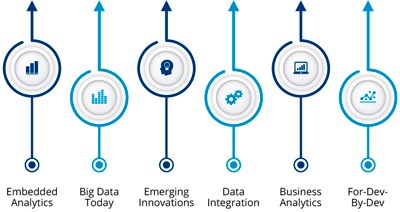

Apresentando a Vantara: uma combinação de TI, tecnologia operacional (OT) e expertise de domínio. Com o software de integração e análise de dados Pentaho, a Vantara oferece às organizações o poder de capturar e usar dados de forma eficiente a partir da "borda", onde os dados são movidos de forma fluida por sensores e dispositivos fora dos internos do negócio do dia-a-dia e combinam estes dados de sensores com recursos de dados corporativos mais tradicionais para fornecer um alto nível de contexto e previsões inteligentes que levam a resultados comerciais reais.

O que dizem os envolvidos

Donna Prlich

CHIEF PRODUCT OFFICER

A integração e análise de dados Pentaho continuará a evoluir, e a Hitachi Vantara irá investir para se manter à frente dos futuros desenvolvimentos em grandes dados, IoT e aprendizagem de máquinas. Sabemos o que nossos clientes precisam e com o poder e os recursos da Hitachi, podemos levá-los até mais rápido.

Pedro Alves

SVP Community / Product Designer for Pentaho at Hitachi Vantara

Não há planos de mudar a estratégia de código aberto ou parar de fornecer uma edição CE para a nossa comunidade! Essa mudança pode acontecer no futuro? Oh, absolutamente sim! Assim como poderia ter mudado no passado. E quando poderia mudar? Quando ele deixa de fazer sentido; quando deixa de ser mutuamente benéfico. E naquele dia, serei o primeiro a sugerir uma mudança em nosso modelo. Se a opensource nos trouxe aqui em primeiro lugar - mudaremos realmente isso agora que as coisas estão se aquecendo? Nós somos loucos, não estúpidos;)

Em resumo, foi criada uma nova empresa com uma estrutura muito maior, chamada Hitachi Vantara, que continuará a trabalhar com o produto Pentaho nas suas versões Enterprise, paga, e Community, gratuita.

Pentaho 8.0

A comunidade está em polvorosa e no evento mundial da Pentaho, o PentahoWorld 2017, que aconteceu na semana passada, entre 25 e 27 de outubro em Orlando na Florida.

A comunidade está em polvorosa e no evento mundial da Pentaho, o PentahoWorld 2017, que aconteceu na semana passada, entre 25 e 27 de outubro em Orlando na Florida.

Entre todos os fantásticos cases apresentados, surgiu mais uma novidade bombástica. Foi anunciado a versão 8 do Pentaho, já para o mês que vem.

- Plataforma e Escalabilidade

- Worker nodes

- Novo tema

- Data Integration

- Suporte de streaming!

- Execute configurações para jobs

- Filtros no Data Explorer

- Nova experiência de Abrir / Salvar

- Big Data

- Melhorias em AEL

- Formatos de arquivo para Big Data - Avro e Parquet

- Segurança em Big Data- Suporte para Knox

- Melhorias de VFS para Clusters de Hadoop

- Outras

- Ops Mart para Oracle, MySQL, SQL Server

- Melhorias na segurança da senha da plataforma

- Mavenization PDI

- Alterações de documentação em help.pentaho.com

- Remoção de recursos:

- Analisador em MongoDB

- Plug-in móvel (desativado em 7.1)

Conclusão

Com investimentos que só uma grande corporação pode fazer, o produto tem tudo para se disseminar ainda mais e ganhar espaço dos grandes players. A equipe de desenvolvimento não para, ao contrário dos concorrentes que só pensam em vender licenças de uso de suas ferramentas. Cada vez mais o pentaho traz segurança, facilidade em desenvolver e manter e o melhor de tudo, com funcionalidades que surpreende até aos mais exigentes. É verdade que ainda são necessários conhecimentos em Java Script e MDX para a implementação de dashboards mais específicos, entretanto aplicações simples, mas e poderosas, podem ser criadas em minutos, sem escrever uma linha de código. O caminho é este.

Com investimentos que só uma grande corporação pode fazer, o produto tem tudo para se disseminar ainda mais e ganhar espaço dos grandes players. A equipe de desenvolvimento não para, ao contrário dos concorrentes que só pensam em vender licenças de uso de suas ferramentas. Cada vez mais o pentaho traz segurança, facilidade em desenvolver e manter e o melhor de tudo, com funcionalidades que surpreende até aos mais exigentes. É verdade que ainda são necessários conhecimentos em Java Script e MDX para a implementação de dashboards mais específicos, entretanto aplicações simples, mas e poderosas, podem ser criadas em minutos, sem escrever uma linha de código. O caminho é este.

E que venha o Pentaho 8.0!

Links Úteis

E para onde foram os fóruns, wikis e comunidades? Abaixo separamos alguns links importantes, que o deixarão com mais segurança:

Referências

- http://www.pentahobrasil.com.br/eventos/pentahoday2017/

- http://pedroalves-bi.blogspot.com.br/2015/02/big-news-today-hitachi-data-systems-hds.html

- http://pedroalves-bi.blogspot.com.br/2017/09/hello-hitachi-vantara.html

- https://www.hitachivantara.com/en-us/news-resources/press-releases/2017/gl170919.html

- http://www.pentaho.com/blog/pentaho-becomes-hitachi-vantara

- https://www.pentahoworld.com/agenda

- http://www.pentaho.com/excellence-awards

- http://pedroalves-bi.blogspot.com.br/2017/10/pentaho80.html

"Não são todos os dias que encontramos tantos profissionais que admiramos de uma só vez. Não poderia deixar de registrar a confraternização com o norte americano Matt Casters, à esquerda, criador do Pentaho Data Integration e o português Pedro Alves, ao centro, o Criador das CTools, amigo e meu instrutor por diversas oportunidades, desde 2012. E isso acontecendo em minha cidade natal, Curitiba. Pentaho Day Brasil 2017"